El archivo robots.txt es una herramienta fundamental en la optimización para motores de búsqueda que permite a los propietarios de sitios web gestionar el acceso de los robots de los buscadores a su contenido. En el contexto de WordPress, contar con un archivo robots.txt bien configurado es crucial para garantizar que los motores de búsqueda indexen adecuadamente las páginas más relevantes de tu sitio, mientras se restringe el acceso a secciones que no deseas que sean visibles en los resultados de búsqueda. Esto ayuda a mejorar la visibilidad de tu sitio y a evitar problemas de contenido duplicado.

Configurar el archivo robots.txt en WordPress es un proceso sencillo que puede realizarse a través de plugins o mediante la edición manual del archivo. Al hacerlo correctamente, puedes especificar qué partes de tu sitio deseas que sean rastreadas o ignoradas por los crawlers. Con una estrategia adecuada en el uso de robots.txt, no solo optimizas tu SEO, sino que también mejoras la experiencia del usuario al dirigir el tráfico hacia el contenido más importante de tu página.

¿Qué es un archivo robots.txt en WordPress?

¿Por qué es importante el archivo robots.txt en WordPress?

El archivo robots.txt es importante porque ayuda a controlar la forma en que los robots de búsqueda interactúan con tu sitio web. Aquí hay algunas razones por las que es importante:- Ayuda a prevenir la indexación de contenido no deseado, como archivos de administración o páginas de error.

- Permite bloquear el acceso a ciertas partes del sitio web para evitar la sobrecarga de tráfico.

- Ayuda a mejorar la seguridad del sitio web al evitar que los robots de búsqueda accedan a información sensible.

¿Cómo funciona el archivo robots.txt en WordPress?

El archivo robots.txt funciona mediante la inclusión de directivas que indican a los robots de búsqueda qué acciones realizar en el sitio web. Aquí hay algunas de las directivas más comunes:- Useragent: especifica el tipo de robot de búsqueda al que se aplica la directiva.

- Disallow: indica que el robot de búsqueda no debe acceder a una determinada URL o directorio.

- Allow: indica que el robot de búsqueda puede acceder a una determinada URL o directorio.

¿Cómo puedo crear y editar el archivo robots.txt en WordPress?

Crear y editar el archivo robots.txt en WordPress es un proceso sencillo. Aquí hay los pasos a seguir:- Accede al panel de administración de tu sitio web de WordPress.

- Haz clic en Ajustes y luego en Lectura.

- En la sección Visibilidad de la página, haz clic en el enlace Archivo robots.txt.

¿Cómo comprobar robot.txt en WordPress?

¿Dónde encontrar el archivo robot.txt en WordPress?

El archivo robot.txt se encuentra en la raíz de tu sitio web. Para acceder a él, debes agregar /robots.txt al final de la URL de tu sitio web. Por ejemplo, si tu sitio web es https://example.com, el archivo robot.txt se encontraría en https://example.com/robots.txt.- Ingresa a la URL de tu sitio web y agrega /robots.txt al final.

- Presiona Enter para cargar la página.

- Si el archivo robot.txt existe, se mostrará en la pantalla.

¿Cómo editar el archivo robot.txt en WordPress?

Para editar el archivo robot.txt en WordPress, debes utilizar un plugin o acceder al archivo directamente mediante FTP. Algunos plugins populares para editar el archivo robot.txt son Yoast SEO y All in One SEO Pack.- Instala y activa un plugin de SEO que permita editar el archivo robot.txt.

- Accede al panel de control del plugin y busca la sección de robots.txt.

- Edita el contenido del archivo robot.txt según tus necesidades.

¿Qué contenido debe tener el archivo robot.txt?

El archivo robot.txt debe contener instrucciones claras para los robots de búsqueda. Algunas de las instrucciones más comunes son Useragent, Disallow y Allow.- La instrucción Useragent se utiliza para especificar qué robots de búsqueda están permitidos o no.

- La instrucción Disallow se utiliza para bloquear el acceso a ciertas partes del sitio web.

- La instrucción Allow se utiliza para permitir el acceso a ciertas partes del sitio web.

¿Dónde subir robots.txt en WordPress?

¿Por qué es importante subir robots.txt en WordPress?

El archivo robots.txt es fundamental para indicar a los motores de búsqueda qué partes de tu sitio web deben ser indexadas y qué partes no. Esto ayuda a mejorar la visibilidad de tu sitio en los resultados de búsqueda y a evitar que se indexen contenido irrelevante o duplicado. Aquí hay algunas razones por las que debes subir robots.txt en WordPress:- Ayuda a mejorar la visibilidad de tu sitio en los resultados de búsqueda.

- Permite controlar qué contenido se indexa y qué no.

- Mejora la seguridad de tu sitio al evitar que se indexen contenido sensible.

¿Cómo subir robots.txt en WordPress?

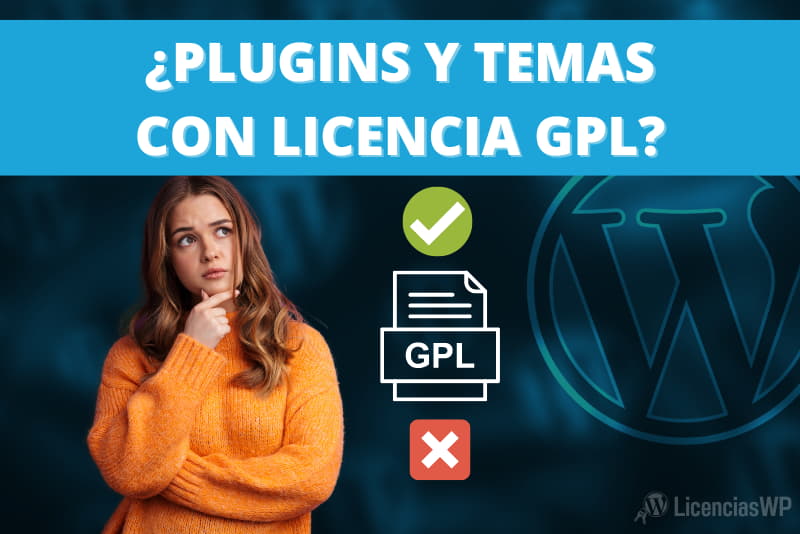

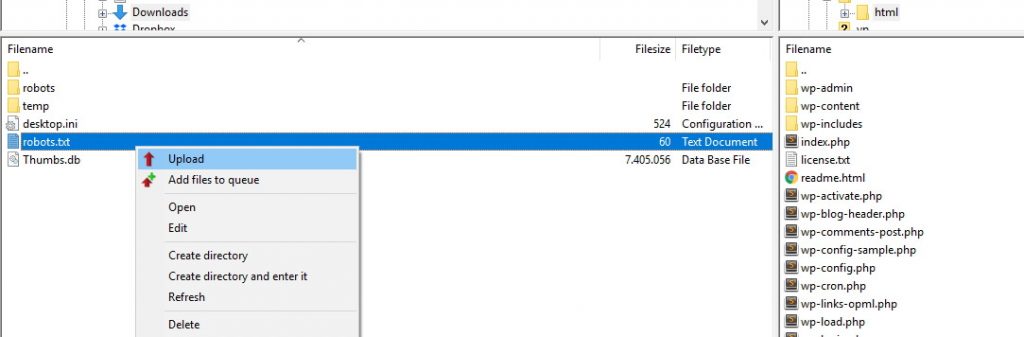

Subir robots.txt en WordPress es un proceso sencillo que requiere acceso al panel de control de tu sitio web. Aquí hay los pasos que debes seguir:- Inicia sesión en el panel de control de tu sitio web.

- Ve a la sección de archivos o FTP.

- Sube el archivo robots.txt a la raíz de tu sitio web.

¿Qué errores comunes debes evitar al subir robots.txt en WordPress?

Al subir robots.txt en WordPress, es importante evitar algunos errores comunes que pueden afectar la visibilidad y la seguridad de tu sitio web. Aquí hay algunos errores que debes evitar:- No subir el archivo robots.txt en la raíz de tu sitio web.

- No configurar correctamente las directivas del archivo robots.txt.

- No actualizar el archivo robots.txt después de realizar cambios en tu sitio web.

¿Cómo elimino un archivo robots.txt de un sitio web de WordPress?

¿Dónde se encuentra el archivo robots.txt en WordPress?

El archivo robots.txt se encuentra en la raíz de tu sitio web, es decir, en la carpeta principal de tu sitio. Puedes acceder a él a través de FTP (File Transfer Protocol) o mediante el panel de control de tu proveedor de hosting. A continuación, te presento los pasos para encontrar el archivo robots.txt:- Inicia sesión en tu panel de control de hosting o abre tu cliente FTP.

- Navega hasta la carpeta raíz de tu sitio web.

- Busca el archivo robots.txt y haz clic en él para abrirlo.

¿Cómo eliminar el archivo robots.txt en WordPress?

Una vez que hayas encontrado el archivo robots.txt, puedes eliminarlo de la siguiente manera:- Selecciona el archivo robots.txt y haz clic en el botón Eliminar.

- Confirma que deseas eliminar el archivo.

- Verifica que el archivo haya sido eliminado correctamente.

¿Qué hacer después de eliminar el archivo robots.txt?

Después de eliminar el archivo robots.txt, es importante verificar que no haya afectado negativamente a tu sitio web. A continuación, te presento algunos pasos para verificar que todo esté funcionando correctamente:- Verifica que tu sitio web esté funcionando correctamente.

- Comprueba que los motores de búsqueda estén indexando correctamente tu sitio web.

- Verifica que no haya errores en la consola de errores de tu sitio web.

Robots.txt en WordPress: Guía completa para principiantes

El archivo robots.txt es una herramienta fundamental en la gestión de sitios web, y WordPress no es la excepción. Este archivo permite a los propietarios de sitios web comunicar a los motores de búsqueda qué partes de su sitio desean que sean rastreadas y cuáles deben ser ignoradas. Para los principiantes, entender cómo funciona este archivo puede ser clave para mejorar la indexación y el posicionamiento en los resultados de búsqueda.

Para configurar el robots.txt en WordPress, puedes hacerlo de varias maneras. Una de las más comunes es a través de plugins de SEO, como Yoast SEO o Rank Math, que permiten personalizar fácilmente el contenido del archivo sin necesidad de conocimientos técnicos. Además, algunos temas de WordPress también ofrecen opciones para editar el archivo directamente desde el panel de administración.

A continuación, se presentan algunos consejos prácticos sobre cómo utilizar el robots.txt de manera efectiva:

- Evita bloquear páginas importantes, como las de productos o servicios.

- Permite que los motores de búsqueda rastreen tu archivo sitemap.xml.

- Utiliza comentarios dentro del archivo para documentar tus decisiones de configuración.

Recuerda que el archivo robots.txt no es una herramienta de seguridad, sino más bien una guía para los bots de búsqueda. Por lo tanto, asegúrate de revisarlo regularmente y ajustarlo según las necesidades de tu sitio web. Un manejo adecuado de este archivo puede marcar la diferencia en la visibilidad de tu contenido en línea.

Cómo generar un archivo robots.txt en WordPress con Yoast

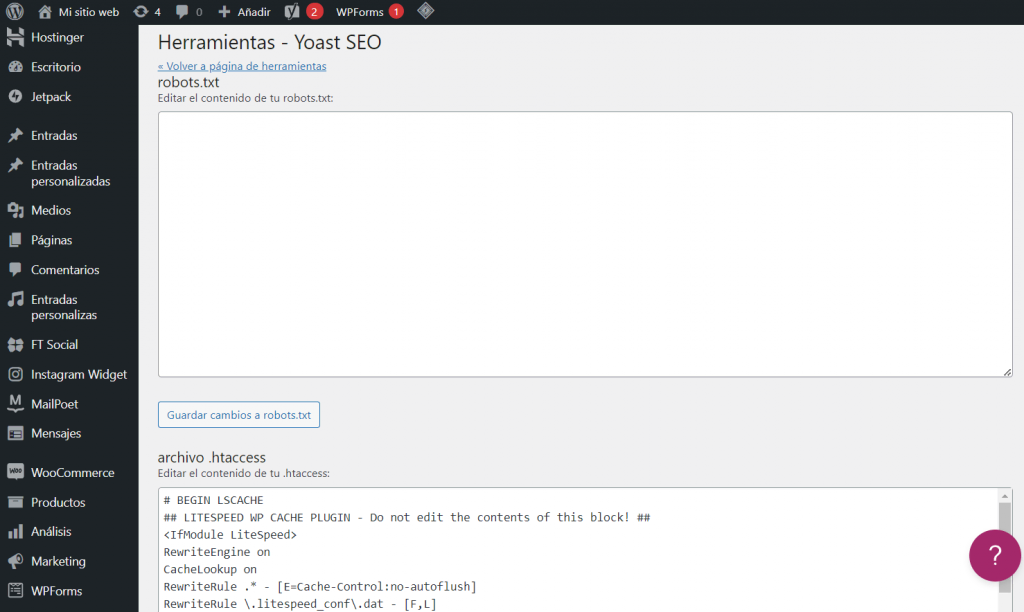

Generar un archivo robots.txt en WordPress utilizando el plugin Yoast SEO es un proceso sencillo que puede mejorar la forma en que los motores de búsqueda interactúan con tu sitio web. Este archivo es crucial para indicar a los motores de búsqueda qué partes de tu sitio deben rastrear y cuáles deben ignorar. Para empezar, asegúrate de tener instalado y activado el plugin Yoast SEO en tu instalación de WordPress.

Una vez que tengas el plugin activo, dirígete al menú de administración de WordPress y selecciona SEO. Desde allí, elige la opción Herramientas. En la sección de herramientas, encontrarás un enlace para Editar el archivo robots.txt. Si aún no tienes un archivo robots.txt, Yoast te dará la opción de crear uno de inmediato.

En la interfaz de edición, podrás personalizar el contenido de tu archivo robots.txt. Es recomendable incluir directrices específicas, como las siguientes:

- User-agent: Define a qué motores de búsqueda se aplican las reglas.

- Disallow: Especifica las URL o directorios que no deseas que sean rastreados.

- Allow: Permite el acceso a URLs específicas, incluso dentro de un directorio restringido.

Una vez que hayas realizado los ajustes necesarios, asegúrate de guardar los cambios. Tu archivo robots.txt estará activo y comenzará a influir en cómo los motores de búsqueda interactúan con tu sitio. Recuerda revisar y actualizar este archivo periódicamente para adaptarlo a las nuevas necesidades de tu contenido.

Ubicación del archivo robots.txt en WordPress: Todo lo que necesitas saber

El archivo robots.txt es una herramienta esencial para gestionar el acceso de los motores de búsqueda a tu sitio web. En WordPress, su ubicación es bastante accesible, ya que se encuentra en la raíz de tu instalación. Esto significa que si tu dominio es www.tusitio.com, el archivo será accesible en www.tusitio.com/robots.txt. Esta ubicación permite a los motores de búsqueda localizarlo fácilmente y seguir las directrices que has establecido.

Para verificar si tu archivo robots.txt está correctamente configurado, simplemente ingresa la URL mencionada en tu navegador. Si no existe un archivo en esa ubicación, WordPress generará uno automáticamente con las configuraciones predeterminadas. Sin embargo, es recomendable personalizar este archivo para optimizar la indexación de tu sitio y evitar que se rastreen áreas que no deseas que sean visibles para los motores de búsqueda.

Algunos aspectos clave que debes considerar al configurar tu robots.txt en WordPress incluyen:

- Permitir o deshabilitar el acceso a ciertas secciones de tu sitio.

- Bloquear el acceso a archivos específicos, como scripts o imágenes, que no son relevantes para el SEO.

- Incluir enlaces a tus sitemaps para facilitar la indexación.

- Utilizar comentarios para aclarar secciones del archivo, lo que puede ser útil para el mantenimiento futuro.

Recuerda que editar el archivo robots.txt puede tener un impacto significativo en cómo los motores de búsqueda interactúan con tu sitio. Por lo tanto, es fundamental realizar cambios con precaución y, si es posible, consultar con un experto en SEO para asegurarte de que estás maximizando el potencial de tu sitio web.

Configurando Disallow: /wp-admin en tu archivo robots.txt

Configurar el archivo robots.txt en WordPress es una tarea esencial para gestionar cómo los motores de búsqueda interactúan con tu sitio. Una de las configuraciones más comunes es la inclusión de la directiva Disallow: /wp-admin, que indica a los bots de búsqueda que no deben acceder al directorio de administración de WordPress. Esto es importante porque el área de administración contiene información sensible y no está destinada a ser indexada por los motores de búsqueda.

Al añadir Disallow: /wp-admin en tu archivo robots.txt, aseguras que las páginas de inicio de sesión y otras áreas administrativas no aparezcan en los resultados de búsqueda. Esto no solo protege la privacidad de tu sitio, sino que también ayuda a evitar que los motores de búsqueda gasten recursos en indexar contenido que no es relevante para los usuarios. Es importante recordar que esta directiva no impide que los usuarios accedan a estas páginas, solo le dice a los motores de búsqueda que no las rastreen.

Además de Disallow: /wp-admin, es recomendable incluir otras directivas que mejoren la eficiencia del rastreo, como:

- Disallow: /wp-includes – Para evitar que se indexen archivos de núcleo de WordPress.

- Disallow: /xmlrpc.php – Para prevenir ataques de fuerza bruta a través de esta función.

- Allow: /wp-admin/admin-ajax.php – Para permitir que se rastreen las solicitudes AJAX necesarias para ciertas funciones del sitio.

Configurar correctamente tu archivo robots.txt no solo optimiza el rendimiento de tu sitio web, sino que también contribuye a una mejor experiencia de usuario al dirigir a los motores de búsqueda hacia el contenido que realmente deseas que se indexe. Recuerda revisar y actualizar tu archivo regularmente para adaptarlo a los cambios en la estructura de tu sitio o en tus objetivos de SEO.

Importancia del robots.txt para el SEO en tu sitio de WordPress

El archivo robots.txt es una herramienta esencial para la optimización en motores de búsqueda (SEO) de cualquier sitio web, incluyendo aquellos que utilizan WordPress. Este archivo le indica a los motores de búsqueda qué partes de tu sitio deben ser rastreadas y cuáles deben ser ignoradas. Al gestionar el acceso de los bots de búsqueda, puedes asegurarte de que solo el contenido relevante y de calidad se indexe, mejorando así la visibilidad de tu sitio en los resultados de búsqueda.

Una correcta configuración del robots.txt puede ayudar a evitar el rastreo de contenido duplicado, páginas de baja calidad o secciones que no aportan valor al usuario. Por ejemplo, si tienes un sitio de comercio electrónico, puedes optar por bloquear el acceso a las páginas de carrito o de pago, ya que estas no son relevantes para la indexación. Esto no solo mejora la eficacia del rastreo, sino que también puede aumentar la autoridad de las páginas que realmente deseas que sean visibles en los resultados de búsqueda.

Además, un archivo robots.txt bien gestionado puede contribuir a una mejor experiencia de usuario. Al reducir la carga en los servidores de tu sitio, los motores de búsqueda pueden indexar el contenido más rápidamente y con mayor eficiencia. Esto es especialmente importante para sitios grandes con múltiples secciones y publicaciones. Una implementación adecuada puede incluir directrices específicas como:

- Bloquear carpetas de administración o de plugins que no son relevantes para el SEO.

- Permitir el acceso solo a aquellas secciones que deseas destacar.

- Evitar el rastreo de archivos temporales o de prueba.

En resumen, el archivo robots.txt es una pieza clave en la estrategia SEO de tu sitio de WordPress. Su correcta optimización no solo mejora la visibilidad de tu contenido, sino que también optimiza el rendimiento del motor de búsqueda, permitiendo que tu sitio se posicione mejor y alcance a un público más amplio.

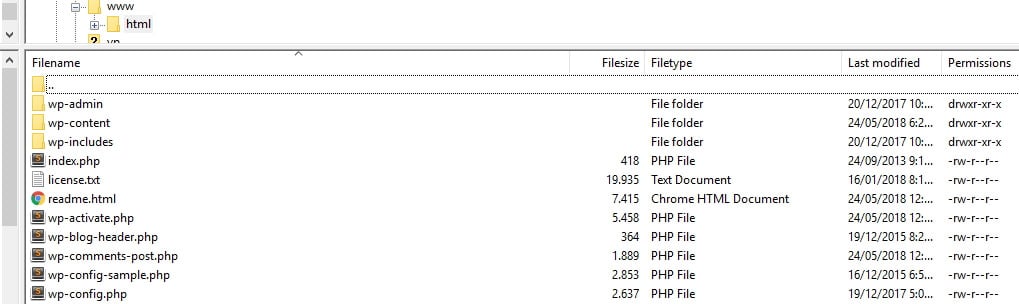

Herramientas para validar tu archivo robots.txt en WordPress

Validar tu archivo robots.txt en WordPress es fundamental para asegurarte de que los motores de búsqueda pueden rastrear tu sitio de manera efectiva. Existen varias herramientas que te permiten verificar la correcta configuración de este archivo, lo que puede influir en la visibilidad de tu contenido. Algunas de las herramientas más populares incluyen:

- Google Search Console: Esta herramienta gratuita te permite comprobar el estado de tu archivo robots.txt y te ofrece sugerencias sobre cómo mejorarlo.

- SEO Site Checkup: Ofrece un análisis detallado de tu archivo robots.txt, identificando posibles errores o restricciones que podrían afectar tu SEO.

- Ahrefs: Con esta herramienta, puedes analizar cómo los motores de búsqueda interactúan con tu sitio y revisar las directrices de tu robots.txt.

- SEMrush: Además de ofrecer auditorías SEO, te permite validar tu archivo robots.txt y proporciona recomendaciones para optimizarlo.

Al utilizar estas herramientas, podrás asegurarte de que tu archivo robots.txt no está bloqueando accidentalmente el acceso a contenido importante. También es recomendable realizar revisiones periódicas, ya que los cambios en tu sitio web pueden requerir ajustes en este archivo para mantener un buen desempeño en los motores de búsqueda.

Además de las herramientas mencionadas, es útil que te familiarices con la sintaxis y las reglas de un archivo robots.txt. Esto te permitirá realizar cambios manualmente si es necesario. Asegúrate de que el archivo esté ubicado en la raíz de tu dominio y que siga las mejores prácticas para que sea efectivo en la gestión del rastreo de tu sitio.